- ホーム

- お役立ち

- Google Service

- AI / ML の自動最適化を実現する方法とは? 効率的なモデル構築に役立つ Google Cloud (GCP)のデータ処理フレームワークを徹底解説!

AI / ML の自動最適化を実現する方法とは? 効率的なモデル構築に役立つ Google Cloud (GCP)のデータ処理フレームワークを徹底解説!

- Dataflow Prime

- Dataproc Hub

本記事は、2021年9月7日に開催された Google の公式イベント「データクラウドサミット」において、 Google Cloud のデータアナリティクススペシャリストであるコントレラ・ダミアン氏が講演された「ストリーミングデータ処理を自動最適化から AI / ML のモデル構築まで、ユーザーのロールに合わせて、データ処理フレームワークを使う」のレポート記事となります。

今回は Google Cloud (GCP)に内包されている多彩なソリューションの中から、 AI / ML の作業効率化を実現するデータ処理フレームワークである Dataproc Hub と Dataflow Prime について詳しくご紹介します。ぜひ最後までご覧ください。

なお、本記事内で使用している画像に関しては、コラボレーションクラウドサミット「ストリーミングデータ処理を自動最適化から AI / ML のモデル構築まで、ユーザーのロールに合わせて、データ処理フレームワークを使う」を出典元として参照しております。

それでは、早速内容を見ていきましょう。

AI / ML におけるモデル構築の課題

昨今、 AI / ML を活用する企業が増えていますが、その一方で様々な課題を抱えているケースも少なくありません。例えば、モデルを構築するための知識や膨大なデータの探索、分析、標準化、また、モデルを学習するためのリソースなどが挙げられます。

本章では、これらの課題について、複数の視点から具体的にご説明します。

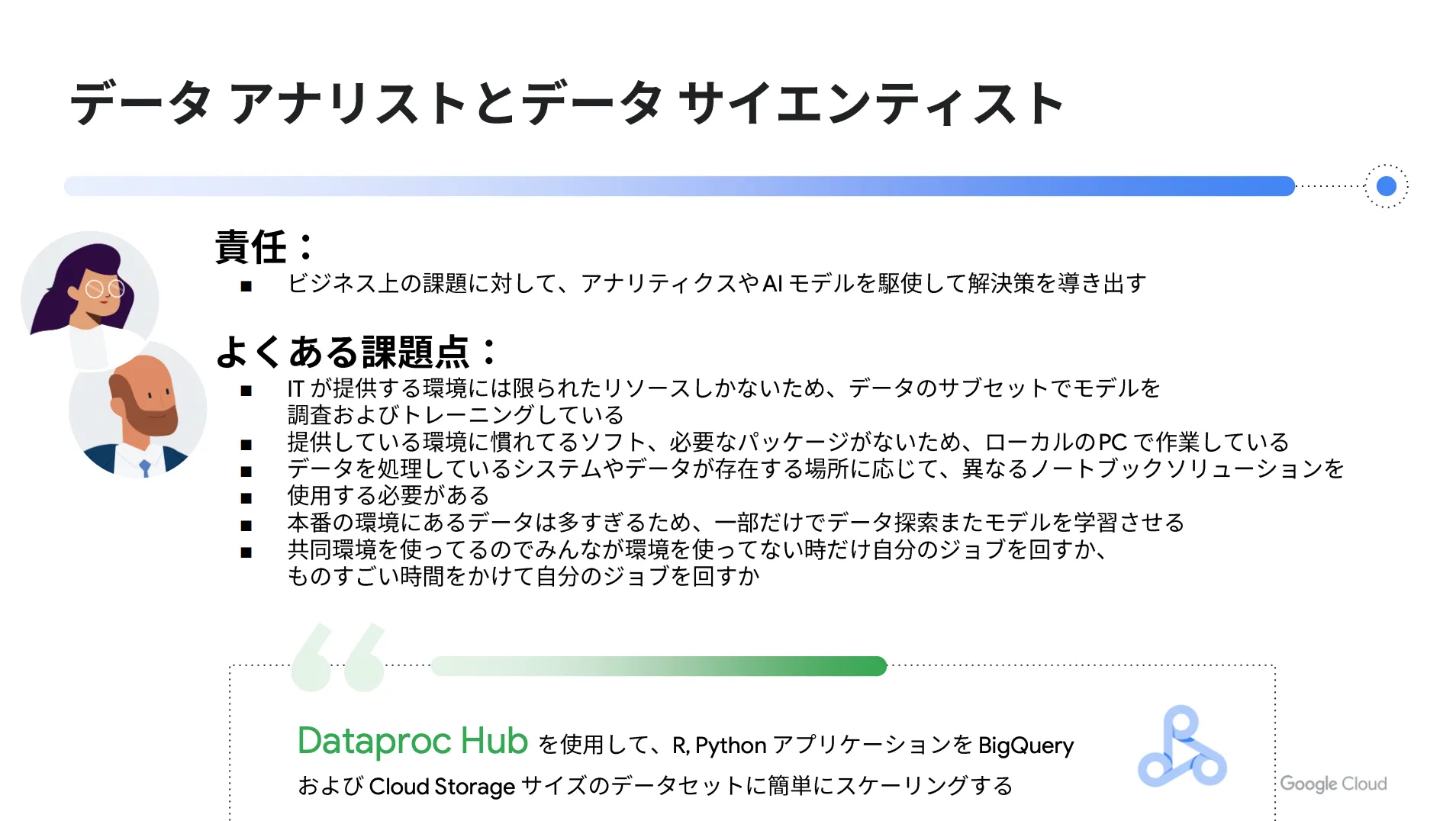

データアナリストとデータサイエンティストの課題

データアナリストやデータサイエンティストの主な役割は、ビジネス上の課題に対して、アナリティクスや AI モデルを駆使して解決策を導き出すことです。しかし、現実には様々な課題があります。

代表的な例としては、データを扱う環境が挙げられます。リソースが限られている場合はデータのサブセットでモデルを調査・トレーニングしなければならず、分析に必要なパッケージがない場合はローカル PC での作業を余儀なくされます。

また、データを処理するシステムやデータが存在する場所に応じて、異なるノートブックを使用するケースもあります。このように AI / ML の分野においては、データアナリストやデータサイエンティストの作業効率を低下させる課題が多く存在しているのです。

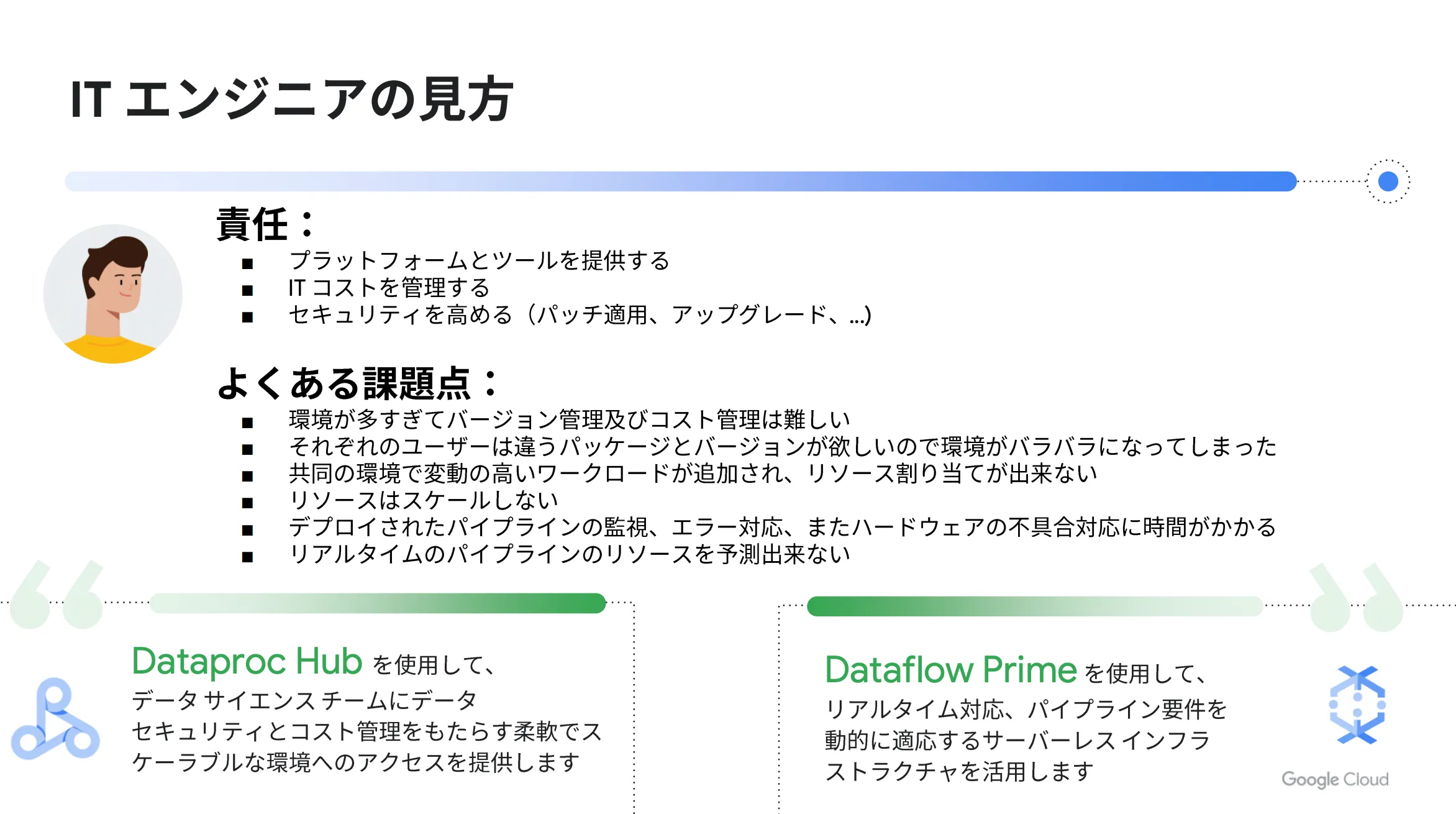

IT エンジニアの課題

IT エンジニアの主な役割は、プラットフォームとツールを提供し、 IT コストを管理することです。加えて、パッチ適用やアップグレードなど、セキュリティの強化も IT エンジニアの仕事になります。

IT エンジニアが抱える課題としては、管理の煩雑さが挙げられます。環境が複数存在している場合、バージョン管理やコスト管理が難しくなり作業が煩雑化します。環境を統一したくても、ユーザーごとに求める要件が異なるため、どうしても環境を分けざるを得ないケースは往々にして存在します。

また、共同環境で変動性の高いワークロードが追加された場合は、リソースの割り当てができません。さらに、デプロイされたパイプラインの監視やエラー対応、ハードウェアの不具合対応などに時間を要する点も IT エンジニアの課題だと言えるでしょう。

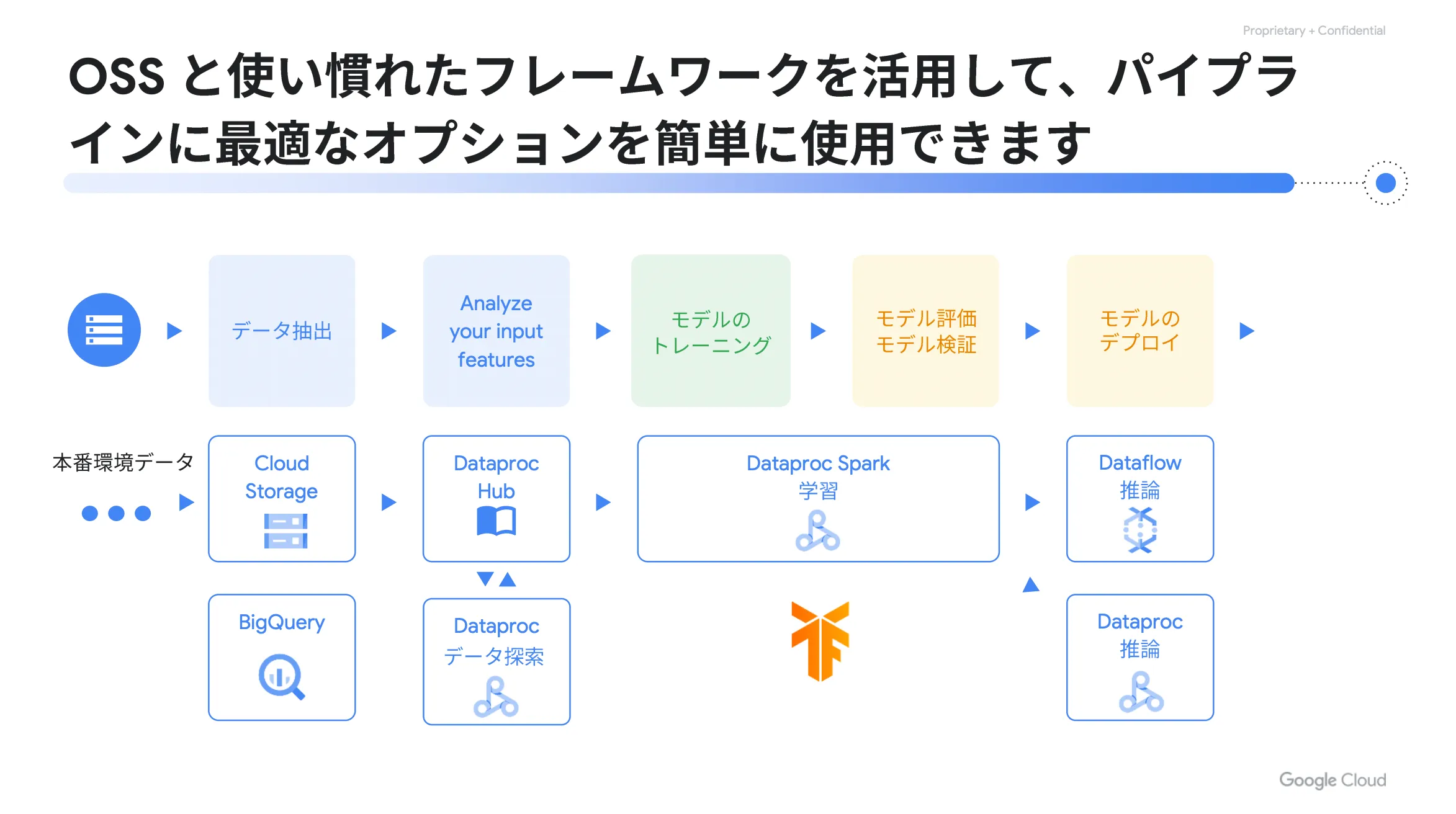

Google Cloud (GCP)を活用したパイプラインの自動最適化

ここまで、各作業者目線の課題をご紹介しましたが、これらを解決するためには Google Cloud (GCP)が有効なソリューションになります。 Google Cloud (GCP)を活用することで、 OSS と使い慣れたフレームワークを活用して、パイプラインに最適なオプションを簡単に使用できます。

例えば、データサイエンティストであれば、本番環境のデータに簡単にアクセスできますし、その際に本番環境のワークロードに負担を掛けることはありません。そして、データサイエンティストであれば、ワークロードの要求に合わせて、必要なリソースを使うことができ、複数処理を並行して行うことも可能です。

また、 Google Cloud (GCP)を活用することで、膨大なデータから必要なデータを素早く探索し、効率的に処理を行うことができます。必要なリソースに合わせて自動的にスケーリングする点も大きな魅力の一つだと言えるでしょう。

Google Cloud (GCP)に搭載されているソリューションは多岐にわたり、目的や用途に合わせて利用できる様々なサービスが用意されています。

今回は、数あるソリューションの中から、 Dataproc Hub と Dataflow Prime の2つをご紹介します。それでは、次章以降で詳しい内容を見ていきましょう。

Google Cloud (GCP)のデータ処理フレームワーク〜 Dataproc Hub 〜

概要

Dataproc Hub は Apache Spark クラスタ、 Presto クラスタ、 Apache Hadoop クラスタなどのオープンソースを簡単かつコスト効率よく実行できるようにする、高速で使いやすいフルマネージドなクラウドサービスです。

Dataproc Hub を活用することで、管理者はデータサイエンティストユーザーのノートブックを手間なく制御および保護することができます。また、データサイエンティスト目線では、フルマネージドな環境で好きなオープンソースツールを使用可能になります。

さらに、 Dataproc Hub には自動スケーリングの機能が搭載されているため、どんなデータサイズに対しても自動的に拡大縮小し、運用工数の削減にも大きく寄与します。

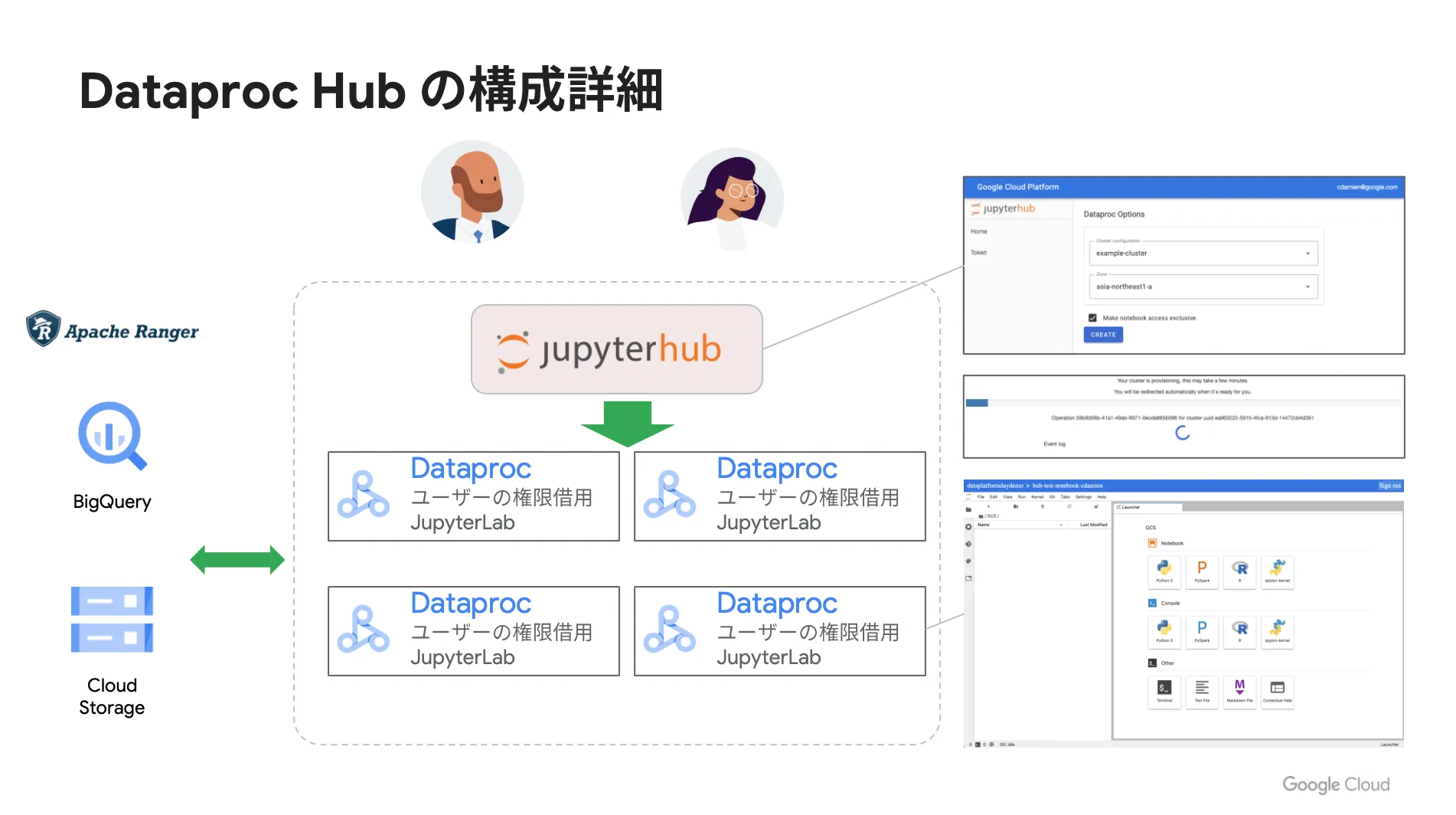

構成

Dataproc Hub では、ノード数や CPU 、 GPU などの使用リソースを細かく自由に設定できます。また、プロビジョニングの管理はデータサイエンティストやデータアナリストが自ら行うことが可能であり、 Dataproc Hub で作り上げた環境で分析の実行やモデルの構築を行った後は、必要に応じて環境を閉じることができます。

処理

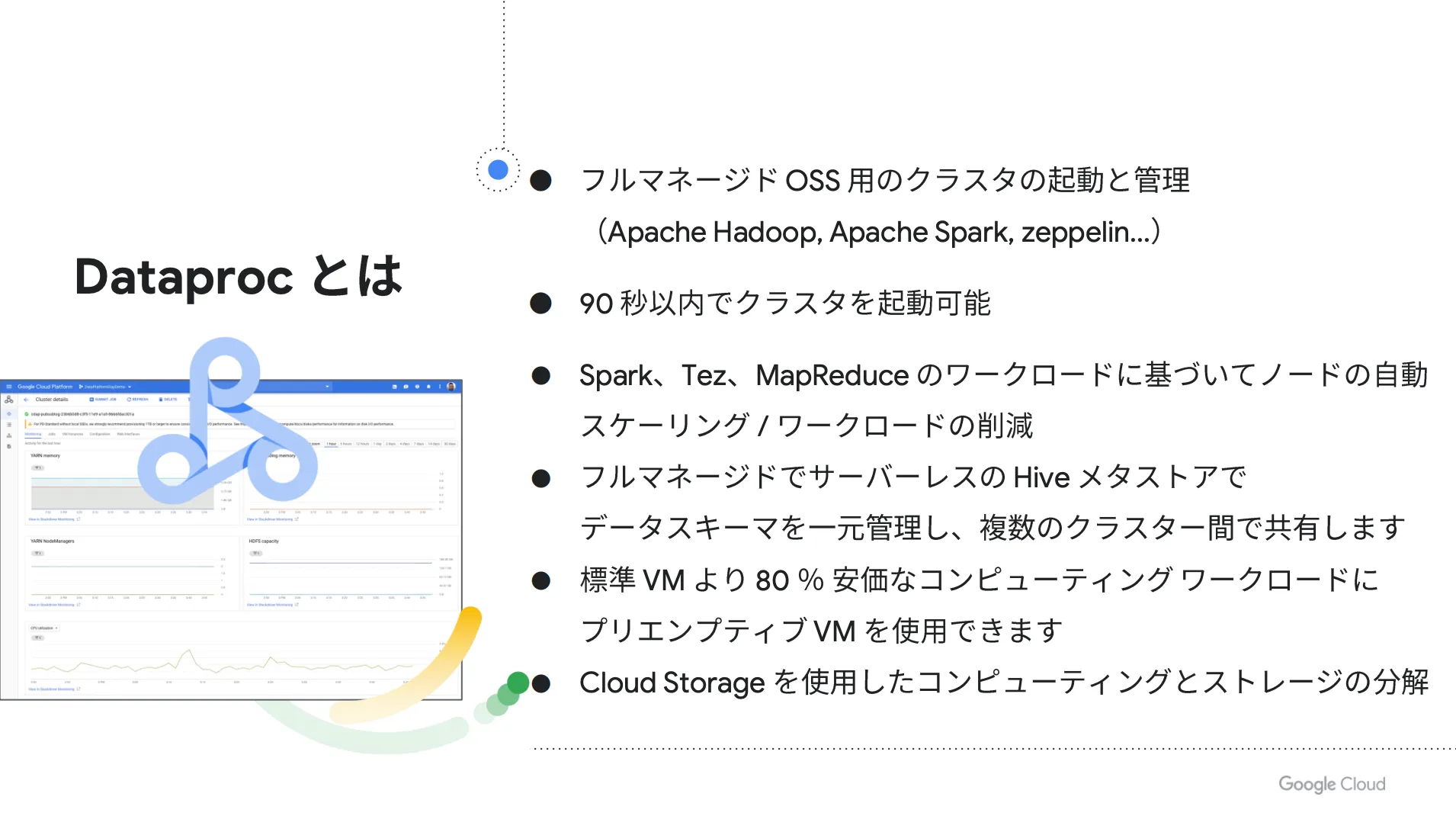

Dataproc Hub の処理は Dataproc をベースとして実行されます。 Dataproc は Google Cloud (GCP) 上で手軽に Hadoop や Spark などのクラスターを立ち上げ、データの解析を行うことができるサービスです

Dataproc を使えば、90秒以内にクラスタを起動することができ、 Spark 、 Tez 、 MapReduce などのワークロードに基づいて、ノードの自動スケーリングやワークロードの削減を実現可能です。それ以外にも、データスキーマの一元管理による複数クラスター間での共有など、様々なメリットが存在します。

活用方法

ここでは、 Dataproc Hub が具体的にどのように使われるのか、作業者ごとの目線に分けてそれぞれご説明します。

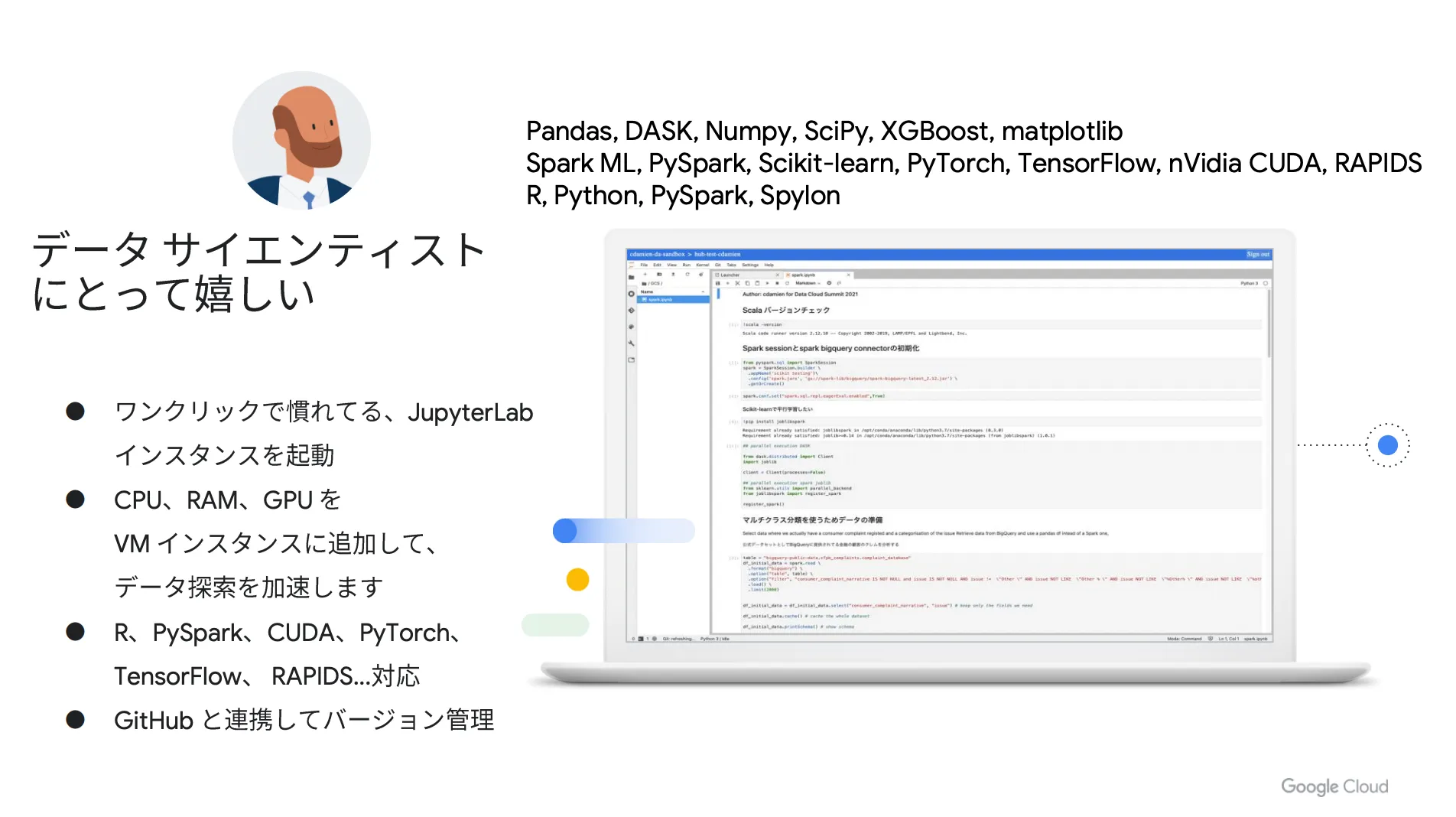

データサイエンティスト目線

Dataproc Hub を活用することでクラスタを簡単に立ち上げることができ、慣れ親しんでいる JupyterLab インスタンスをワンクリックで起動することが可能です。また、 CPU や RAM 、 GPU などを VM インスタンスに追加して データ探索を加速したり、 GitHub と連携すればバージョン管理を行うこともできます。

このように、 Dataproc Hub を使えば煩雑な作業は不要になります。まさに、データサイエンティストの業務効率化や生産性向上に直結するソリューションだと言えるでしょう。

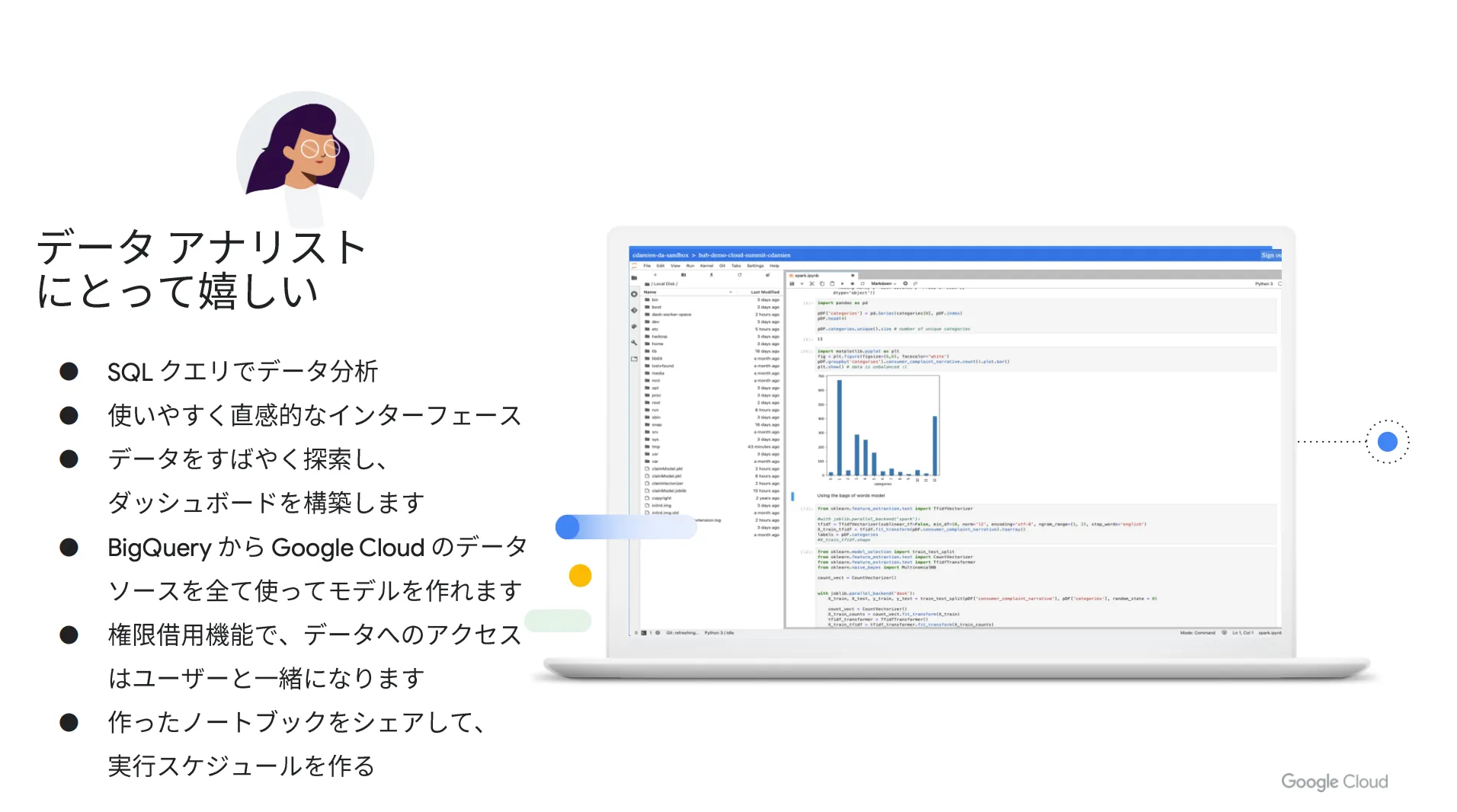

データアナリスト目線

Dataproc Hub を使えば、 SQL クエリでデータ分析を行うことができます。また、データを素早く探索してダッシュボードを構築できたり、 BigQuery から Google Cloud (GCP)のデータソースを使ってモデルを構築することも可能です。

さらに、作ったノートブックをシェアして実行スケジュールを作成することもでき、使いやすく直感的なインターフェースを採用している点も嬉しいポイントです。このように、データサイエンティストと同様、データアナリストにとっても Dataproc Hub は便利なソリューションであることがわかります。

IT エンジニア目線

Dataproc Hub の活用により、 YAML ファイルでクラスターの標準化を実現することができます。また、クラスターの CPU や GPU 、メモリサイズなどのリソースタイプに制限をかけたり、自動スケーリングの有効・無効を設定することも可能です。

さらに、 Dataproc Hub はフルマネージドで提供されているサービスであるため、リソースの管理や監視は不要になります。このように、 Dataproc Hub は IT エンジニアの運用工数の削減や業務効率化に直結するソリューションであると言えるでしょう。

Google Cloud (GCP)のデータ処理フレームワーク〜 Dataflow Prime 〜

Dataflow とは?

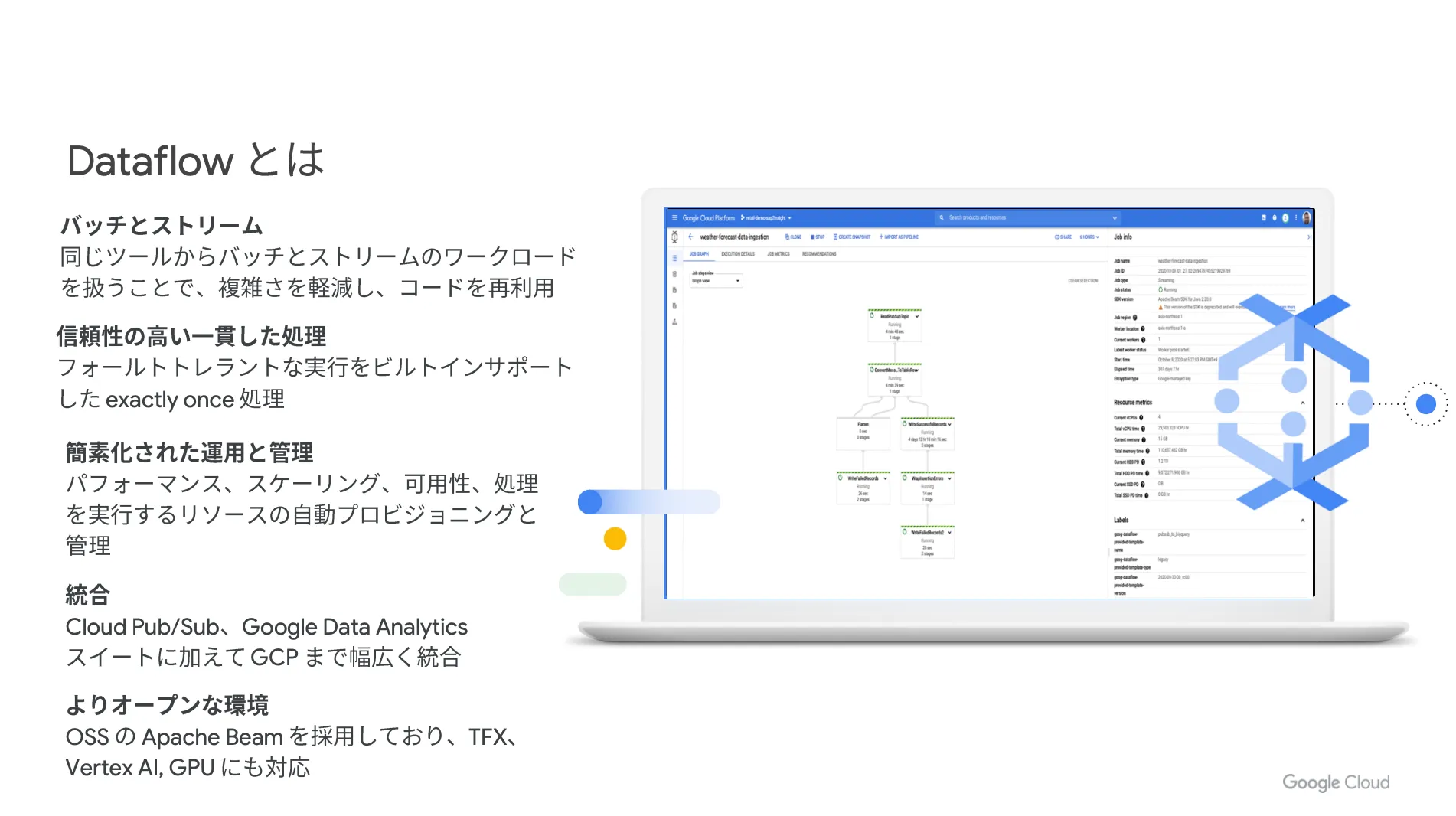

Dataflow は Google Cloud(GCP)に内包されている ETL ツールであり、サーバーレスかつフルマネージドのデータ処理サービスです。

Java や Python で処理を作り込むことができるのはもちろん、標準で提供されているテンプレートを使うことも可能です。クラウドストレージにアップロードした JDBC ドライバーを使用して、 Netezza や Exadata に接続できるテンプレートも用意されています。

また、 Dataflow は「 Apache Beam (オープンソースのフレームワーク)」で構築されたパイプライン処理を実行できるプラットフォームであり、 Apache Beam の実行環境としても利用することができます。パイプライン処理とは、マイクロプロセッサ内部での命令を分割し、それぞれを別の回路で実行することで、並行的に処理を進めるための技術です。

企業が保有する大規模かつ多岐にわたるデータを一元的に集約し、高速にデータを処理できる Dataflow は、企業がデータ活用を進める上で心強い武器になります。情報量の増加やデータの多様化が進み、企業におけるデータ活用の重要性が高まっている現代において、 Dataflow はあらゆる企業にとって必要なサービスだと言えるでしょう。

さらに、ノートブックから直接 Dataflow のジョブを起動することができ、開発者はインタラクティブな環境でパイプラインのプロトタイプを開発できます。これにより、パイプラインを構築しながら検査をしたり、実行中のデータを可視化することも可能になります。

Dataflow に関心のある方は以下の記事が参考になります。

Google の ETL サービス「 Dataflow 」とは?概要、特徴、できること、料金体系まで徹底解説!

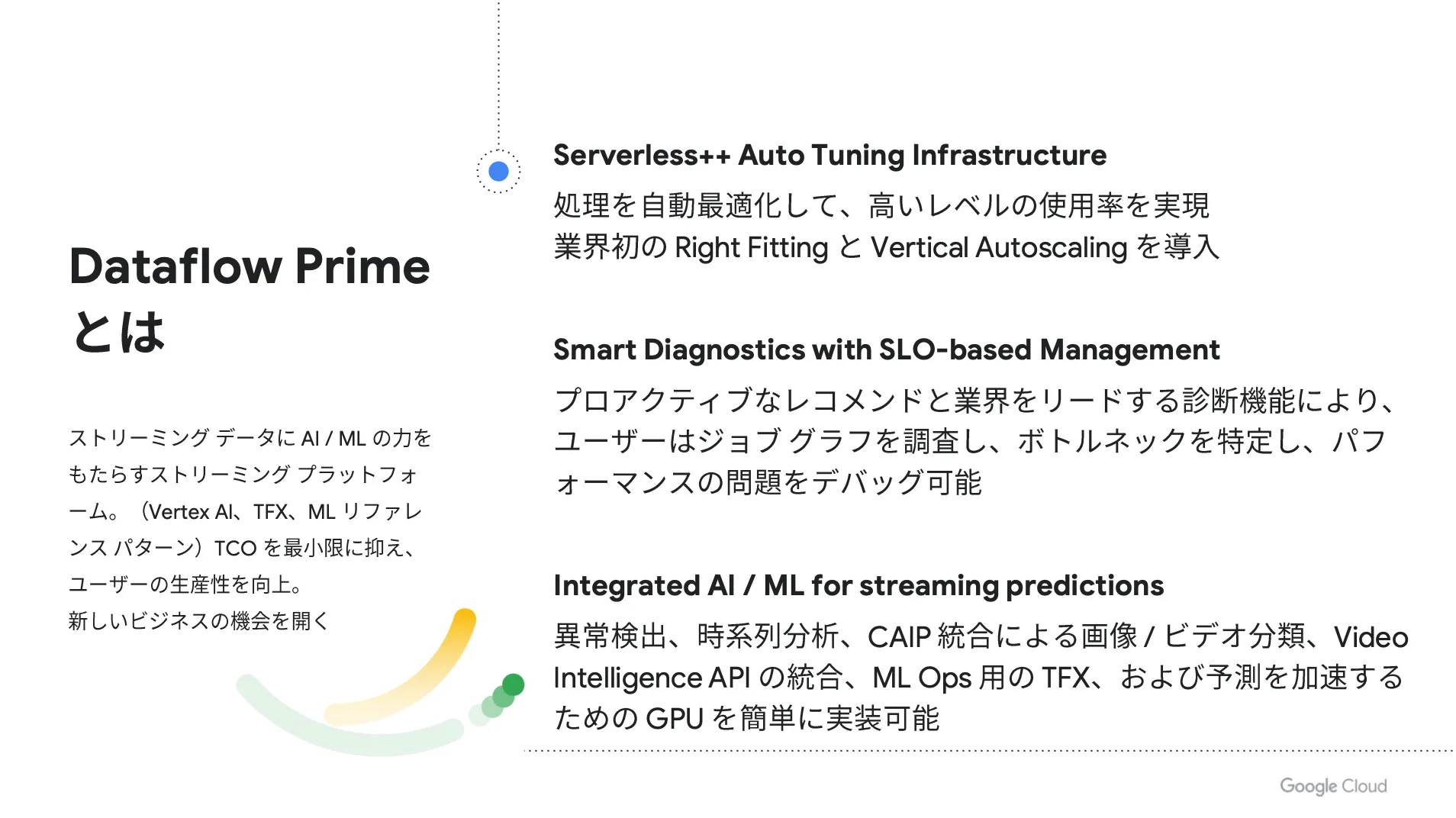

Dataflow Prime とは?

Dataflow Prime は、ストリーミングデータに AI / ML の力をもたらすストリーミングプラットフォームです。業界初となる Right Fitting と Vertical Autoscaling を導入し、処理を最適化して高いレベルの使用率を実現しています。

また、プロアクティブなレコメンドと業界をリードする診断機能により、ユーザーはジョブグラフを調査し、ボトルネックを特定し、パフォーマンスの問題をデバックすることが可能です。さらに、予測を加速するための GPU を簡単に実装できる点も嬉しいポイントです。

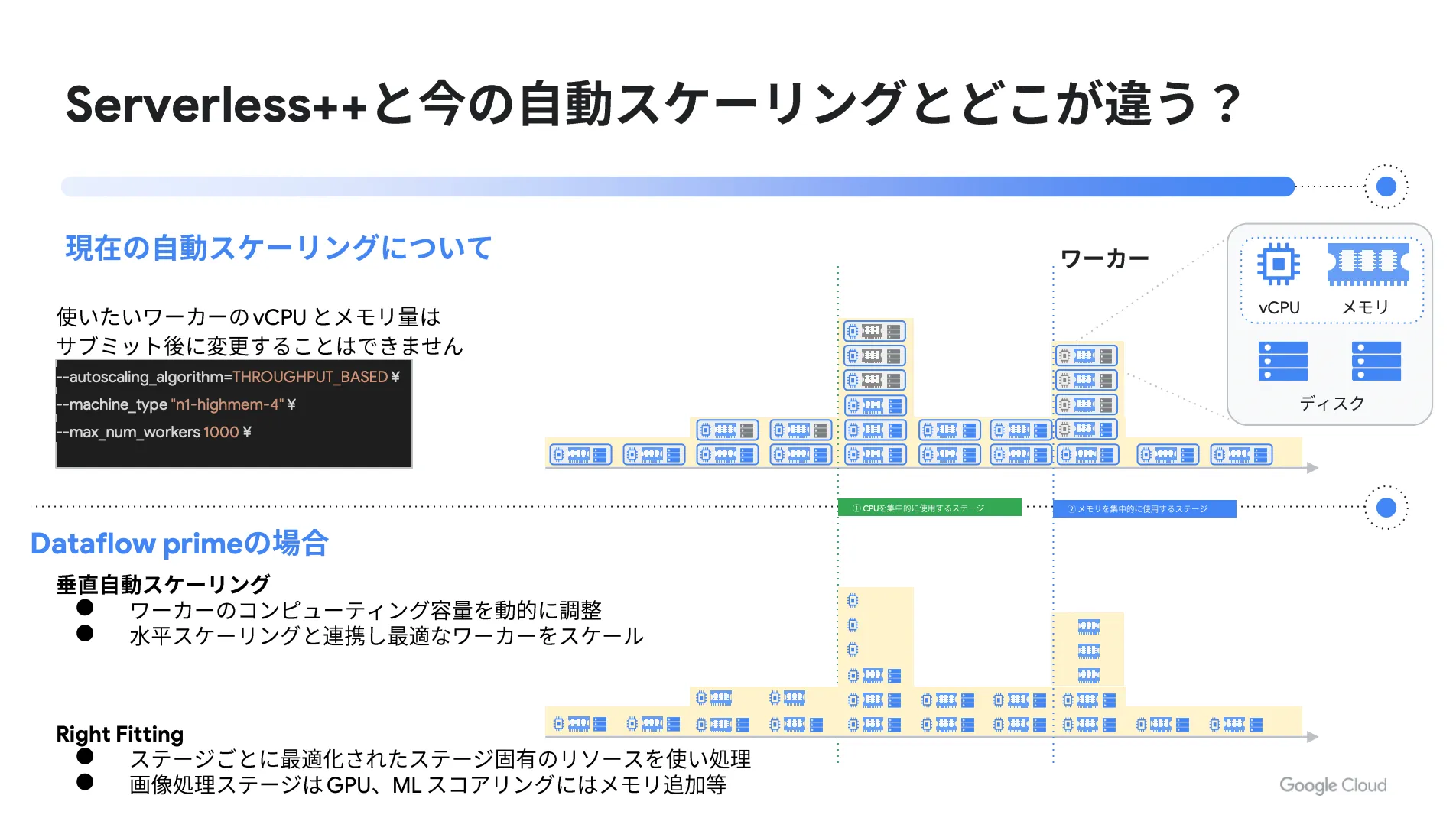

Serverless++ と従来の自動スケーリングとの違い

Dataflow Prime は Serverless++ を採用していますが、従来の自動スケーリングと比較して、具体的にどのような違いがあるのでしょうか?

従来の自動スケーリングでは、使いたいワーカーの vCPU とメモリ量をサブミット後に変更することはできませんでしたが、 Dataflow Prime の場合、ワーカーのコンピューティング容量を動的に調整し、水平スケーリングと連携しながら最適なワーカーをスケールします。

そのため、 Dataflow Prime を活用することで、今まで以上に柔軟な運用が可能になり、運用工数の削減や生産性向上を実現することができます。

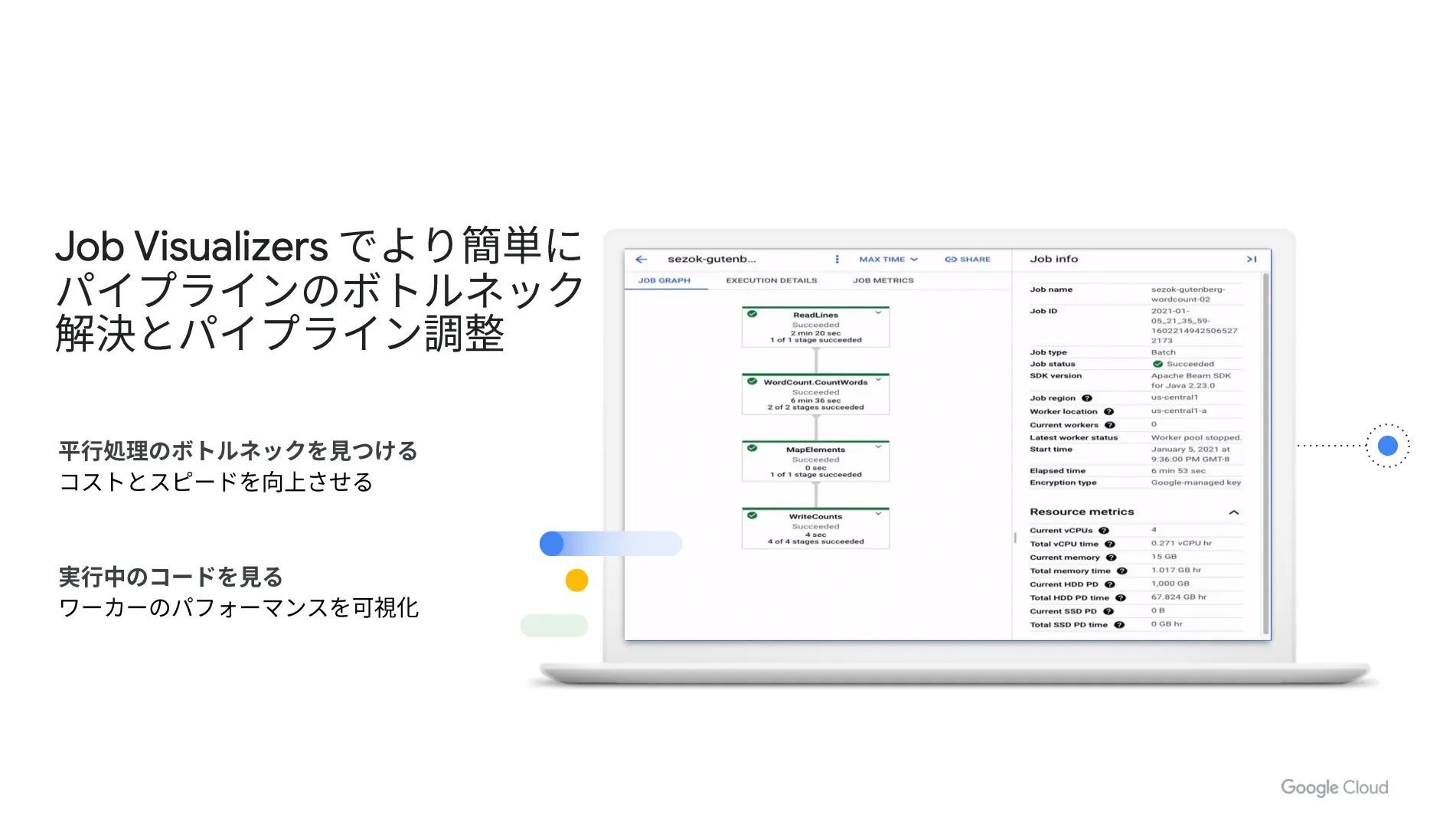

新機能1: Job Visualizers

直近で Job Visualizers という新機能がリリースされました。これは、並行処理のボトルネックを見つけることでコストとスピードを向上させ、実行中のコードをチェックすることでワーカーのパフォーマンスを可視化するものです。

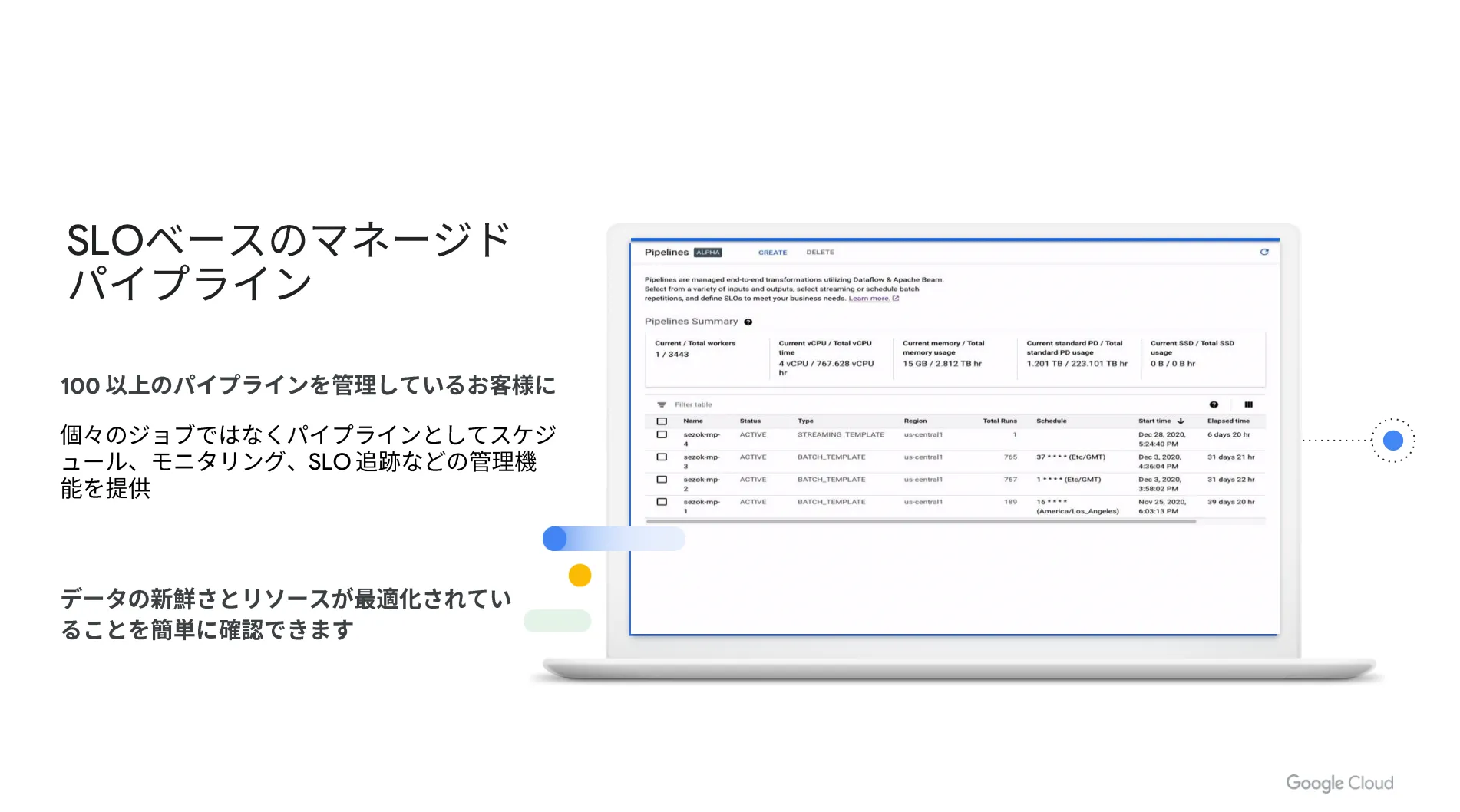

新機能2: SLO ベースのマネージドパイプライン

Job Visualizers とあわせて、 SLO ベースのマネージドパイプラインも最近リリースされました。個々のジョブではなく、パイプラインとしてスケジュールやモニタリング、 SLO 追跡などの管理が可能になるため、多数のパイプラインを管理している企業に有効なソリューションだと言えます。

まとめ

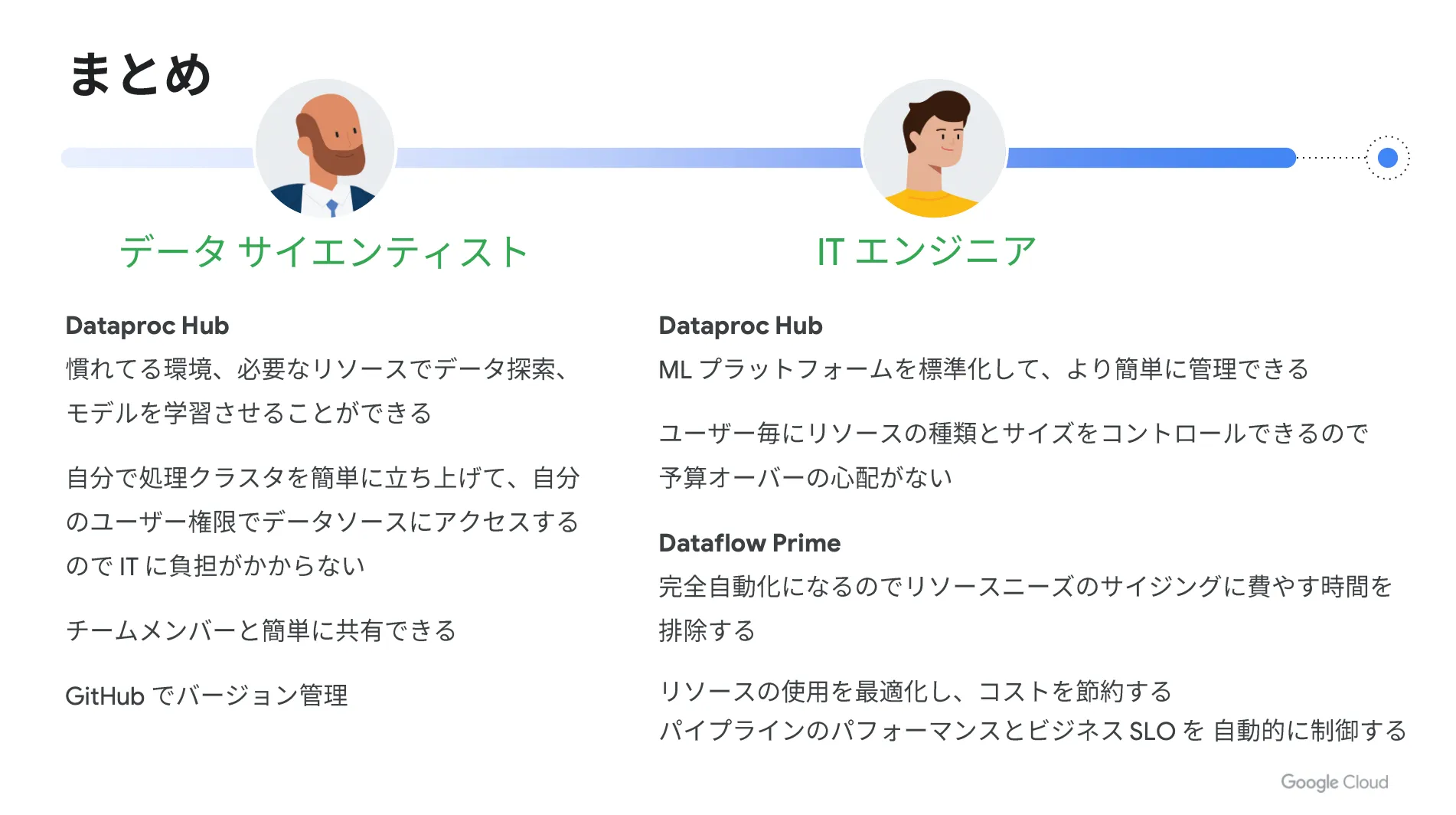

本記事では、 Google Cloud (GCP)に内包されている多彩なソリューションの中から、 AI / ML の作業効率化を実現するデータ処理フレームワークである Dataproc Hub と Dataflow Prime について詳しくご紹介しました。

Google Cloud (GCP)には様々なソリューションが用意されていますが、今回取り上げた Dataproc Hub と Dataflow Prime を活用することで、データサイエンティストや IT エンジニアの大幅な生産性向上を実現することができます。

以下、記事の内容を1枚のスライドでまとめます。

昨今、データ活用の重要性は年々高まっており、その中で AI / ML における業務上の課題が多く存在しています。今回ご紹介した Google Cloud (GCP)の機能を使えば、これらの課題を解決し、自社の AI / ML 活用を大きく前進できます。

G-genは、Google Cloud のプレミアパートナーとして Google Cloud / Google Workspace の請求代行、システム構築から運用、生成 AI の導入に至るまで、企業のより良いクラウド活用に向けて伴走支援いたします。

Contactお問い合わせ

Google Cloud / Google Workspace導入に関するお問い合わせ