LLM におけるパラメータとは? AI 性能との関係性や調整方法などを徹底解説

- 生成AI

昨今、 ChatGPT や Gemini をはじめとした LLM (大規模言語モデル)が登場したことで、私たちの生活はより便利になりました。また、日常生活だけではなく、ビジネス領域においても AI の活用が加速しており、様々なシーンで LLM が使われています。

そして、 LLM の性能を向上させるためには、パラメータがとても重要な要素になります。本記事では、 LLM におけるパラメータの重要性や代表的な調整方法、調整時のポイントなど、あらゆる観点から一挙にご説明します。

LLM とは?

LLM は「 Large language Models 」の略であり、日本語では「大規模言語モデル」と呼ばれています。大規模言語モデルという名前の通り、 LLM は非常に大規模なデータをもとに学習を行います。

具体的な学習データの例としては、 Web 上のコーパス(自然言語の文章・使い方などを広く収集し、コンピューターで検索できるように整理されたデータベース)や書籍、ニュース記事、会話ログなどが挙げられます。

昨今、 LLM の活用シーンは多岐にわたり、

- 情報検索の精度向上

- テキストの自動要約

- 会話エージェントの開発

- 翻訳の支援

など、あらゆる場面で LLM の活用が進んでいます。

この他にも、医学・法律分野における文書作成のサポートなど、専門知識が求められる特定領域への応用も期待されており、 LLM は日常生活やビジネスにおいて、大きな影響を与える技術の一つであると言えるでしょう。

LLM に関しては以下の記事で詳しく解説しています。

関連記事:LLM (大規模言語モデル)の仕組みとは?生成 AI との違いや活用事例などを一挙に紹介!

LLM におけるパラメータとは?

パラメータとは、 AI モデルが学習した情報を保持し、与えられた指示に対する出力を決定するための数値のことです。パラメータはモデルが膨大なデータを学習する過程で調整されることが多く、言葉の意味や文脈、関係性などを表現する役割を果たしています。

そして、パラメータの数が多いほど、 AI モデルはより複雑なパターンや文脈を理解できるようになります。このように、パラメータは AI の賢さを支える基盤であるとご理解ください。

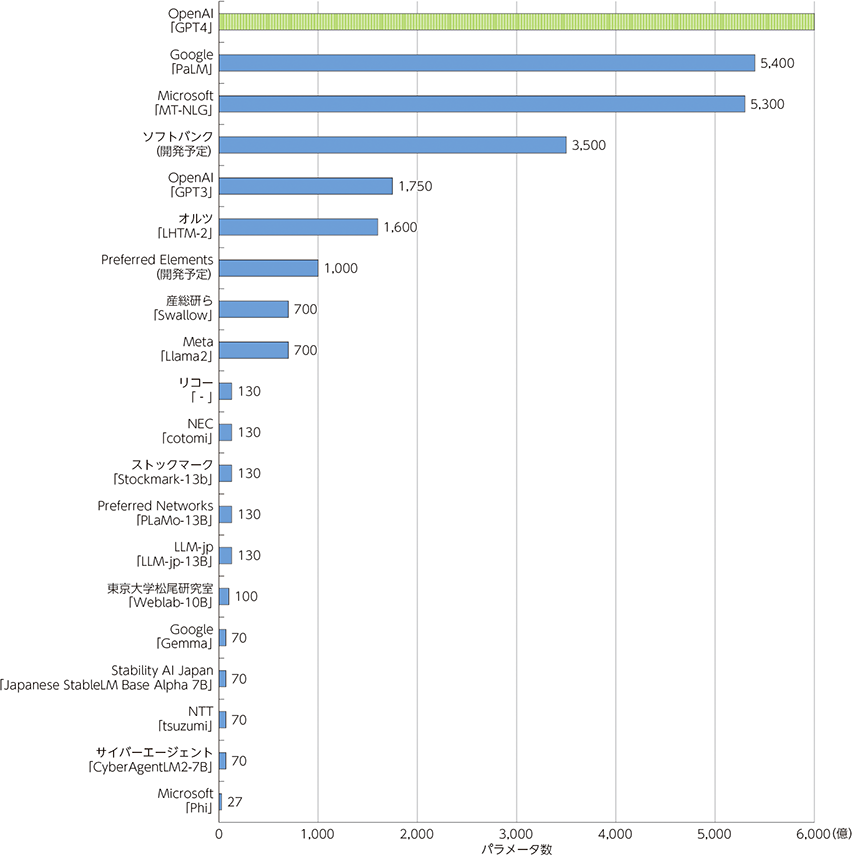

以下、参考までに主要な LLM のパラメータ数を掲載します。

※出典:総務省 HP 「主要な LLM の概要」

パラメータの重要性

LLM において、パラメータはモデルの性能を決定づける重要な要素の一つになります。パラメータは特定の単語間の関連性や文脈の理解、さらには複雑なパターンの認識に直接関与するため、パラメータが正確に調整されることで、 AI は自然な文章生成や高度な推論が可能になります。

そして、パラメータが多いことは、 LLM の知識の深さと幅広さに直結します。数十億、あるいは数千億といった膨大なパラメータを持つ LLM は、より微細な文脈や抽象的な概念を捉える能力を持ちます。

その結果、曖昧な質問や創造性が求められるタスクにも柔軟に対応できるようになります。ただし、単純にパラメータを増やせばよいというわけではなく、パラメータの増加は計算コストやエネルギー消費の増大を伴うため、効率性と性能のバランスが重要だと言えるでしょう。

このように、 LLM におけるパラメータはとても重要な意味を持っています。パラメータの質と量を最適化することで、 AI は高度かつ多様なタスクをこなせるようになり、私たちの生活やビジネスにおける AI の価値を一層高めることができるのです。

ハイパーパラメータとの違い

パラメータと混同しやすい言葉として、ハイパーパラメータが挙げられます。これは AI モデルの学習プロセスをコントロールする設定値のことであり、学習率やバッチサイズ、層の数などが該当します。

ハイパーパラメータは開発者が事前に決めることが多く、 AI の学習方法を設計するために使われます。つまり、パラメータは AI が学習で身に付ける知識そのもの、ハイパーパラメータは学習方法を設計するための設定だと捉えるのが理解しやすいでしょう。

LLM のパラメータ数が上がることによるメリット

ここまで、パラメータの概要について解説しましたが、パラメータの数が増えることでどのような恩恵を受けられるのでしょうか。本章では、 LLM のパラメータが上がることによるメリットを 3 つご紹介します。

汎化能力が向上する

パラメータ数が増えるとモデルの汎化能力が向上します。汎化能力とは、学習データに依存することなく、未知のデータにも適切に対応できる能力のことを意味しています。

パラメーターが多ければ、より詳細なパターンや文脈の違いを理解しやすくなるため、過去に例がない質問に対しても適切な応答を生成できます。これにより、モデルは特定の分野だけでなく、幅広いシナリオで正確かつ自然な出力を提供することが可能になります。

パフォーマンスが向上する

パラメーター数が増えることで、モデルのパフォーマンスが大幅に向上します。ここで言うパフォーマンスとは、文章生成の質や応答の正確性、さらには複雑なタスクをこなす能力を指しています。

パラメータが多いモデルは深い学習が可能であり、微妙な言葉のニュアンスや文脈の裏側にある意味を捉える力が強化されます。その結果、自然で説得力のある応答や、高度な推論を必要とする場面においても、優れた処理能力が期待できます。

多種多様なタスクに適応できる

パラメータ数の増加は、多種多様なタスクへの適応力を高める効果もあります。パラメータが増えることで、モデルが学習できる情報量が格段に増加し、様々な分野の知識やスキルを同時に扱えるようになります。

例えば、文章の要約や感情分析、質問応答、翻訳、創作など、異なる性質のタスクを一つのモデルでこなすことができます。これにより、 LLM は特定の目的に縛られることなく、幅広い用途で使える万能なツールとして活躍するでしょう。

代表的な LLM パラメータの調整方法

LLM のパラメーターを調整する方法は多岐にわたり、それぞれ異なる特徴を持っています。本章では、代表的な LLM パラメーターの調整方法を 3 つご紹介します。

グリッドサーチ

グリッドサーチとは、パラメータ調整の中で最もベーシックな手法であり、各パラメータの候補値をあらかじめリストアップしたうえで、それらの組み合わせを網羅的に試して評価を行います。

例えば、

- 学習率: 0.01 、 0.1 、 1.0

- バッチサイズ: 16 、 32 、 64

という候補値を設定した場合、合計で 9 通りの組み合わせを試すことになります。

グリッドサーチのメリットは、最適解に近い設定を見つけられる可能性が高い点です。ただし、試行回数がパラメーター数や候補値の数に比例して増えていくため、大規模モデルや多数のパラメーターを扱う場合は、計算コストが上がりやすい点に注意しておきましょう。

ランダムサーチ

ランダムサーチとは、パラメータごとに設定した範囲内でランダムに値を選び、試行することで最適な組み合わせを探る手法です。ランダムサーチの最大のメリットとしては、試行回数を大幅に削減できる点が挙げられます。

例えば、同じ 9 通りのパラメーター空間をランダムサーチで探索する場合、あらかじめ試行回数を 5 回と決めて実施することが可能です。これにより、コストを抑えつつ、最適解に近いパラメータを効率的に見つけられますが、運に左右される側面があることは覚えておきましょう。

ベイジアン最適化

ベイジアン最適化とは、過去の試行結果をもとに次に試すべきパラメータを予測し、その後の探索を進めていく手法です。ベイジアン最適化を行うことで、試行回数を最小限に抑えながら、効率よく最適なパラメーターを見つけることができます。

グリッドサーチやランダムサーチが不要な試行を重ねる可能性があるのに対して、ベイジアン最適化は無駄を減らすように設計されています。そのため、計算資源が限られている環境や、高精度な調整が求められる場面では、ベイジアン最適化が有効な選択肢になります。

ただし、ベイジアン最適化の実装や設定はやや複雑であり、初心者が扱うのは難しいケースも存在します。このような理由から、自社でベイジアン最適化を実践する場合は、 AI に関する専門知識を持った IT 人材の確保が求められるでしょう。

LLM パラメーターを調整する際のポイント

LLM パラメーターの調整においては、意識すべき注意点が存在します。最後に、 LLM パラメーターを調整する際のポイントを 3 つご紹介します。

目的に合わせた設定を意識する

LLM を使用する際には、はじめに目的を明確化することが大切です。

具体例として、 LLM には「温度( temperature )」というパラメーターが存在しますが、これは生成するテキストのランダム性や創造性を調整するための役割を果たします。そして、このパラメーターを調整することで、応答の特性をコントロールできます。

例えば、正確性が重視される場面では、温度のパラメーターを低めに設定することで、論理的かつ安定した出力を得られます。一方、創造性が求められる場面では、このパラメータ設定を高めに変更することで、自由な発想が得られるようになり、ストーリー作成やアイデア発想に適した応答が期待できます。

このように、パラメータ調整を行う際は、何のために使うのかを決めてから作業を進めるように意識しましょう。

ユーザー体験の向上に繋がる応答設計を行う

多くのビジネスシーンにおいては、 LLM を使うこと自体が最終的なゴールではなく、 LLM を活用してユーザーに価値を提供することが求められます。そのため、パラメータ調整を行う際は、いかにユーザー体験を最適化するかという視点を持つことが大切です。

例えば、短い質問に対しては簡潔な応答を、詳細な説明が必要な質問には十分な長さの応答を返すことで、ユーザーの満足度を高められます。そして、応答の長さは「最大トークン数( max tokens )」というパラメータの設定が大きく影響しますが、長すぎる応答は読み手に負担を与えますし、短すぎる応答は情報不足を感じさせてしまいます。

このように、ユーザー体験を向上させるためには、パラメータを絶妙なバランスで設計することが大切です。これにより、 AI は自然で魅力的な応答を生成できるようになり、ユーザーの満足度向上に繋がります。

リソースを最適化する

LLM はその性能の高さゆえに、一定の計算リソースやコストを伴うため、効率的に運用することが求められます。例えば、タスクが比較的シンプルな場合は、小型モデルや軽量化手法を採用することで無駄を省けます。

また、応答速度が重視されるリアルタイム処理では、トークン数やバッチ処理の設定を適切に調整すれば、遅延を抑えることが可能になります。このように、必要な性能を満たしつつも、無駄なリソースを消費しないように運用環境や予算に合った最適化を意識することが重要なポイントです。

まとめ

本記事では、 LLM におけるパラメーターの重要性や代表的な調整方法、調整時のポイントなど、あらゆる観点から一挙にご説明しました。

企業が適切なパラメータ調整を実践することで、 LLM のパフォーマンス向上や多種多様なタスクへの適応など、様々なメリットを享受できます。この記事を読み返して、代表的なパラメーターの調整方法や、調整を行う際のポイントなどを理解しておきましょう。

G-genは、Google Cloud のプレミアパートナーとして Google Cloud / Google Workspace の請求代行、システム構築から運用、生成 AI の導入に至るまで、企業のより良いクラウド活用に向けて伴走支援いたします。

サービスを見る

サービス資料をダウンロードする

無料で相談する

本記事を参考にして、 LLM の活用およびパラメーター調整の実践を検討してみてはいかがでしょうか?

Contactお問い合わせ

Google Cloud / Google Workspace導入に関するお問い合わせ