言語生成AI におけるトークンとは?重要性やトークン化の作業イメージなどを解説

- 生成AI

近年、生成 AI が目まぐるしい進化を遂げています。代表的なものとしては、 ChatGPT や Gemini をはじめとした生成言語 AI が挙げられ、日常生活やビジネスシーンなど、様々な場面で有効活用されています。

そして、生成言語 AI について考える際には、トークンがとても重要な要素の一つになります。本記事では、生成言語 AI におけるトークンの概要や重要性、トークン化の作業イメージなどを一挙に解説します。

生成言語 AI とは?

まずは、前提知識として生成言語 AI の基本を理解しておきましょう。

生成言語 AI とは、人間のように自然な文章を作り出すことができる生成 AI の一種です。例えば、チャットやメール文面の作成、さらには小説や詩の創作まで、様々なシーンで活用されています。

そして、生成言語 AI の技術を支えているのが大規模言語モデル( LLM )と呼ばれる AI モデルです。 LLM は膨大なテキストデータを学習しているため、言葉の意味や文脈を理解し、それらに基づいて適切な文章を生成することが可能です。

生成言語 AI の強みとしては、単に決められたパターンを繰り返すのではなく、質問の内容や文脈を考慮して、その場に応じたオリジナルな応答を作り出せる点です。これにより、会話形式の AI アシスタントや、自動で記事を生成するツールとしても利用されています。

LLM に関心のある方は以下の記事が参考になります。

関連記事:LLM (大規模言語モデル)の仕組みとは?生成 AI との違いや活用事例などを一挙に紹介!

トークンとは?

トークンとは、 AI がテキストの理解や生成を行う際に扱う単位のことです。簡単に言えば、文章を分解した小さなパーツの一つひとつがトークンであり、 AI はこのトークンを学習や処理を行うための最小単位として使用します。

例えば、「彼は職場に行きます」という文章を AI が処理する場合、これをそのままの形で使うのではなく、まずはトークンの単位に分解します。具体的には、「彼」「は」「職場」「に」「行き」「ます」のように、小さい単位に分けられるのです。

分割の仕方は AI の設計や言語によって異なりますが、その目的は AI が文章の意味や構造を効率よく理解することです。テキストをトークン化することで、 AI がその文章をより深く理解でき、結果としてユーザーが求める最適な回答を返せるようになります。

生成言語 AI におけるトークンの重要性

生成言語 AI において、トークンはとても重要な要素の一つになります。本章では、生成言語 AI におけるトークンの重要性を 3 つの観点からご説明します。

AI の理解力を支える基盤になる

トークンは生成言語 AI がテキストを読む際に最初に行う分割の結果です。文章を細かく分けることで、 AI が一つひとつの要素を認識し、テキスト全体の文脈や意味を把握できるようになります。このように、トークンを用いた細かな単位での分析が、生成言語 AI が自然な文章を理解し、生成する能力を支えているのです。

AI のパフォーマンスに影響する

トークンの数が増えるほど、 AI はより多くの情報を処理しなければならず、その分だけ計算が複雑になります。一方、効率的なトークン化を行うことで、無駄の少ない処理が可能になり、自然で意味の通った文章を生成できます。特に長文のやり取りでは、トークン数が AI の応答速度や生成結果の質に直接影響を与えるため、トークンの重要性は非常に高いと言えます。

AI の利用コストに直結する

生成言語 AI を利用する際、トークンはコストを左右する重要な要素になります。例えば、多くの生成 AI プラットフォームでは、テキスト生成時に発生する料金がトークン数によって計算されることが一般的です。「簡潔な応答」と「詳細な解説」では、必要なトークン数が異なり、同じ質問でもコストに違いが生じる場合があるため、このような観点からもトークンの重要性は高いと言えるでしょう。

代表的なトークン化の手法

AI がテキストをトークン化する際には、様々な方法が用いられます。本章では、代表的なトークン化の手法を 3 つご紹介します。

単語トークン化( Word Tokenization )

単語トークン化は、文章を単語ごとに分割するトークン化の手法です。例えば、「私は猫が好きです」という文章を単語トークン化すると、「私」「は」「猫」「が」「好き」「です」といった形で、各単語が一つのトークンになります。この方法は直感的でわかりやすく、人間の言語感覚にも近いため、最もシンプルなトークン化手法として広く使われています。

ただし、単語トークン化は未知の単語やスペルミスに対応するのが難しく、語尾の変化(「走る」と「走った」など)を別々のトークンとして扱ってしまうリスクがあるため、この点には注意が必要です。とは言え、自然言語処理の初歩的なモデルでは、効率的に文章を扱える方法として、この単語トークン化が積極的に活用されています。

文字トークン化( Character Tokenization )

文字トークン化は、文章を 1 文字ごとに分割する手法です。先程の例で言えば、「私は猫が好きです」という文章を文字トークン化した場合、「私」「は」「猫」「が」「好」「き」「で」「す」という形で、各文字がそれぞれのトークンになります。この方法は非常に細かく、すべての文字を独立した要素として扱うため、未知の単語やスペルミスにも対応しやすいというメリットがあります。

一方で、文字単位で分割するためにトークン数が膨大になりやすく、モデルの処理負荷が増加する点が大きな課題だと言えるでしょう。また、文字単位では文脈や意味を直接把握しづらいため、高度な言語理解が求められるタスクでは不向きなケースも存在します。

サブワードトークン化( Subword Tokenization )

サブワードトークン化は、単語トークン化と文字トークン化の中間に位置する手法です。文章を単語の一部や接頭辞・接尾辞などに分解するため、未知の単語に対して強い点が大きな特徴として挙げられます。

例えば、「走りました」というテキストをサブワードトークン化する場合、

- 「走」「り」「ま」「した」

- 「走」「りました」

のように、状況に合わせた分割が行われます。

サブワードトークン化は、頻出する単語はそのままトークンとして扱い、未知の単語はさらに分解するような柔軟性を持っているため、複雑かつ前例のないようなテキストを扱う際にも有効に活用できます。

Gemini、BERT や GPT などの生成 AI モデルもサブワードトークン化を採用しており、未知の単語に対応しつつトークン数を抑えられる、というバランスの良さから、処理効率と応答の質を両立できる手法として注目を集めています。

トークン化を行う時のポイント

トークン化を行う際には、意識すべき点がいくつか存在します。本章では、トークン化を行う時のポイントを 3 つご紹介します。

言語の特性を理解する

トークン化を成功させるためには、対象となる言語の特性を理解することが欠かせません。例えば、英語は単語の間にスペースがあるため、単語ごとに簡単に分割できますが、日本語や中国語はスペースがなく、単語の境界を認識するのが難しくなります。

また、日本語では「は」や「が」などの助詞が重要な役割を果たすため、これらを正確にトークン化できることが文脈の理解に繋がります。このように、言語の特性に応じて最適なトークン化の手法を選ぶことで、 AI の性能を最大限に引き出すことが可能になります。

適切なトークンサイズを選ぶ

トークン化を行う際、トークンをどの程度の大きさで分割するのかはとても重要な要素になります。前述した通り、単語トークン化は文章の意味を捉えやすいですが、未知の単語や複雑な構造には対応しにくい場合があります。

一方、文字トークン化は細かく分けることで未知のデータにも対応できますが、トークン数が増えすぎて処理が非効率になるリスクがあります。そのため、使用するモデルや目的に合わせて、適切なトークンサイズを選ぶことが重要なポイントになります。

処理効率とモデル性能のバランスを考慮する

トークン化は AI の性能だけでなく、計算コストにも直結します。トークンが増えすぎるとモデルの処理が重くなり、応答速度が遅くなったり、利用コストが上がったりする可能性があります。

一方、トークン数を減らしすぎると重要な文脈情報が失われ、生成される文章の質が低下することが考えられます。そのため、処理効率とモデル性能のバランスを見極め、自社にとって最適な形でトークン化を進めることが大切です。

トークン化の実際の作業イメージ

最後に、トークン化の実際の作業イメージをご紹介します。

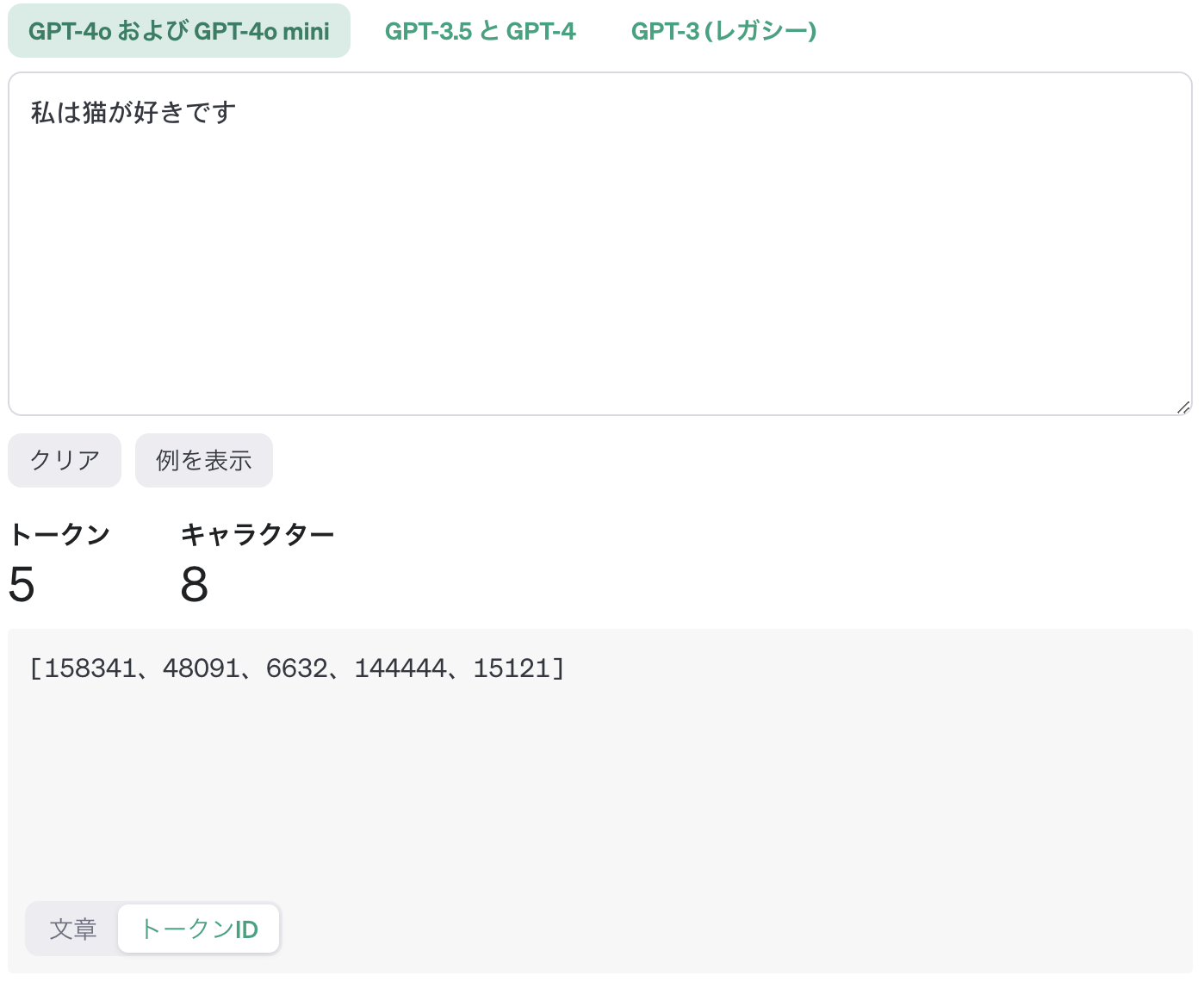

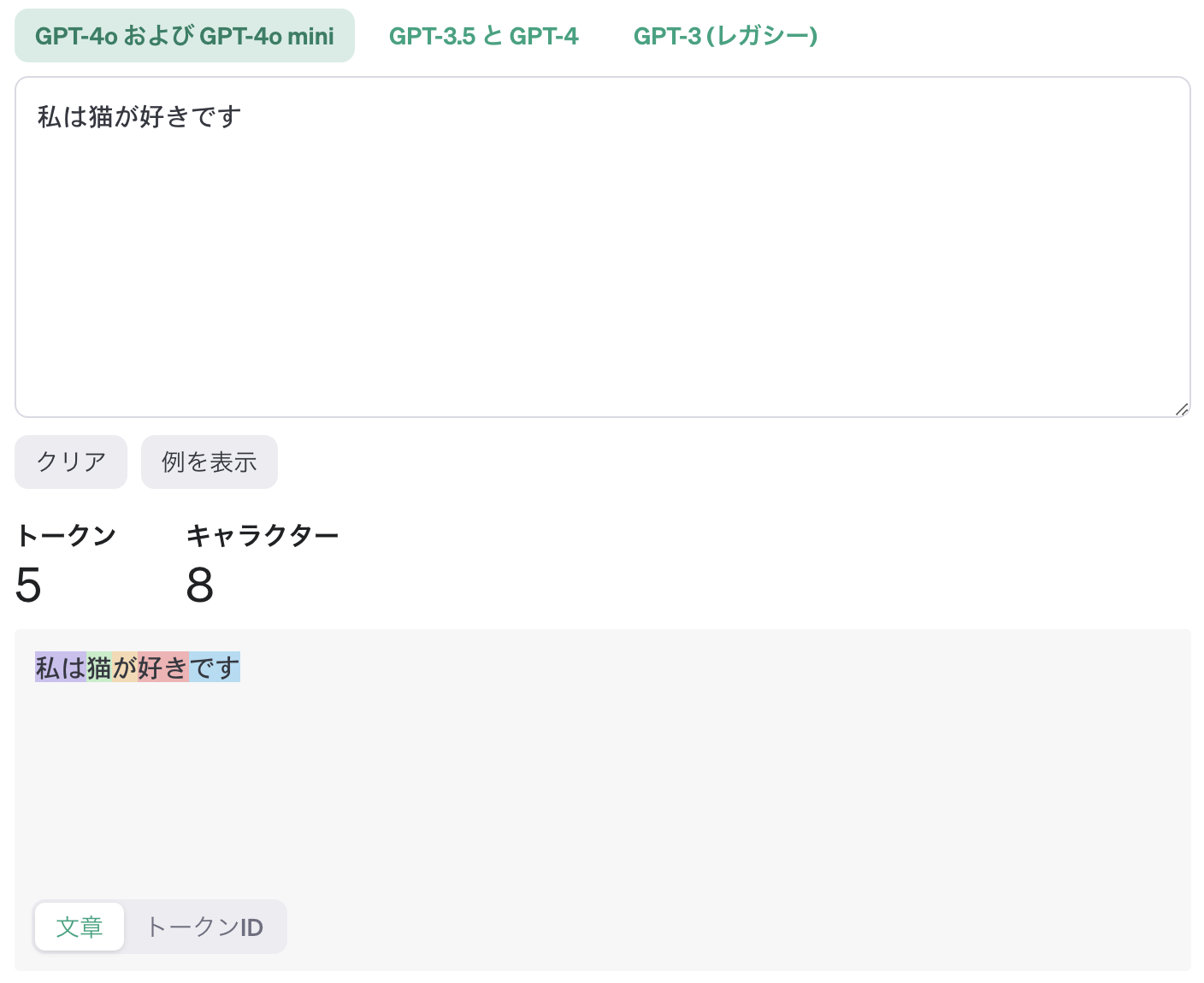

OpenAI 社の Web サイト上で「トークナイザー」というツールが公開されており、これを使えば簡単にテキストをトークン化できます。

今回は「私は猫が好きです」という文章を日本語・英語のそれぞれで入力してみます。

以下、日本語で入力した場合の出力結果です。

次に、英語で入力してみましょう。

このように、日本語で入力した場合のトークン数は 5 であるのに対して、英語の場合は 3 という結果になりました。つまり、英語で入力した方が使用するトークンを節約できることになります。

また、日本語で入力した場合のトークンを細かく確認すると、次のような結果になりました。文章に色が付いている部分がトークンの分割箇所を表しています。

上図を見る限り、 1 文字につき 1 トークンとしては扱われていないため、文字トークン化を使っていないことがわかります。

このように、トークン化は入力するテキストの言語に応じてトークン数も変動します。 ChatGPT の場合、トークン数に応じて料金が決まるため、トークン化の仕組みを理解することでコストを低減できると言えるでしょう。

今回は非常にシンプルなテキストを例に挙げましたが、トークン化という作業をイメージするための参考情報として捉えていただければと思います。

まとめ

本記事では、生成言語 AI におけるトークンの概要や重要性、仕組みなどを解説しました。

生成言語において、トークンは AI のパフォーマンスや利用コストを左右する重要な要素になります。この記事を読み返して、代表的なトークン化の手法や実際の作業イメージなどを理解しておきましょう。

G-genは、Google Cloud のプレミアパートナーとして Google Cloud / Google Workspace の請求代行、システム構築から運用、生成 AI の導入に至るまで、企業のより良いクラウド活用に向けて伴走支援いたします。

サービスを見る

サービス資料をダウンロードする

無料で相談する

本記事を参考にして、生成言語 AI の活用を検討してみてはいかがでしょうか?

Contactお問い合わせ

Google Cloud / Google Workspace導入に関するお問い合わせ